AI活用ロードマップ

導入の仕方がおかしいから、手間ばかりが増えるわけで……

AIは「魔法の杖」ではなく「新たな同僚」

はじめに

世の中には「AIを使えば何もかも自動化できる」といった、浮足立った言葉が溢れています。 最近では「プロンプトさえ学べば稼げる」といった安易な風潮も目につきますが、実務の現場はそれほど単純ではありません。 ドメイン知識や設計思想を持たないまま言葉を弄んでも、現場で機能するシステムは決して生まれないからです。

長年ITインフラの最前線に身を置いてきた私の視点から見れば、AI導入は決して魔法ではありません。 それは新たな「知的リソース」を既存のシステムに統合する、極めて現実的で泥臭いアーキテクチャ構築そのものです。

本記事は、IT部門の担当者やPM・PL、そして説明責任を担うPMOなど、実務の実装責任を負うプロフェッショナルのために執筆しました。 AIという未知の力をいかに「確かな実務」へと落とし込むか。 単なる流行の追随ではなく、持続可能な運用のための「設計図」を求める方にこそ、この4つのフェーズを読み進めていただきたいと考えています。

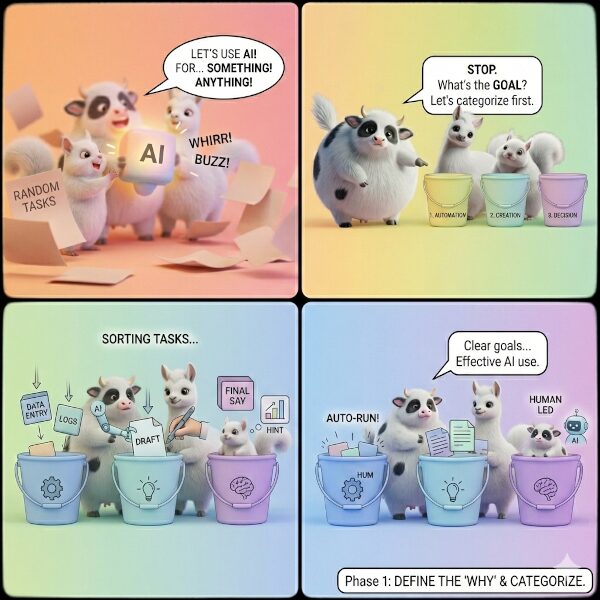

Phase 1: 目的定義とタスクの構造化(AI活用の方向性を定める)

AI活用の成否は、技術選定以前に「業務をいかに構造化できるか」にかかっています。 PMやPLが最初に取り組むべきは、現場に散乱するタスクをその性質に基づいて分類し、AIというリソースを適切に配分する「設計」の工程です。

「とりあえずAI」という手段の目的化を避ける

プロジェクトが失敗する典型的なパターンは、「AIを使って何かできないか」という手段の目的化です。 新しい技術への好奇心は重要ですが、実務においては「解決すべき課題」の具体化が最優先されます。 まずは既存の業務を棚卸しし、以下の3つのカテゴリーに分類して整理することから始めましょう。

業務の3分類とAIの機能配分

- 定型業務(Automation):ルールに基づく効率化 データ入力やログ監視など、手順が明確な作業がこれに当たります。 Pythonスクリプト等とAIを組み合わせることで、最も高い導入効果が期待できる領域です。

- 創造的業務(Creation):判断のためのドラフト作成 ドキュメントの素案作成やコードの雛形生成、あるいはブレインストーミングの壁打ちなどです。 AIに「0から1」を作らせ、人間がそれを研磨することで、生産性を劇的に高めます。

- 判断業務(Decision):人間が負うべき実装責任 最終的な意思決定や、複雑な利害関係が絡む対人折衝などがこれに該当します。 ここはAIに委ねてはならない「人間の聖域」であり、AIは判断材料を提供する参謀に留めます。

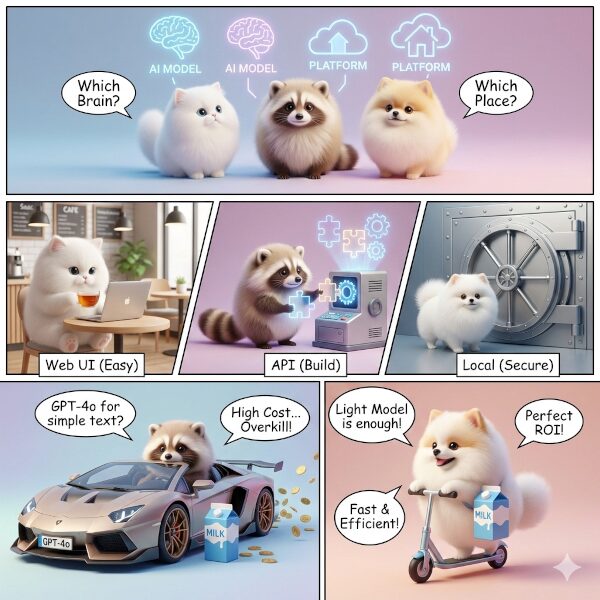

Phase 2: モデル選定と環境構築(最適な「脳」と「場所」を選ぶ)

Phase 1で業務の構造化を終えたら、次は「どのAI(脳)」を「どこ(場所)」で動かすかの設計に入ります。 PMやPLにとって重要なのは、最新モデルを追うことではなく、コスト・セキュリティ・運用負荷のバランスを最適化する「説明責任」を果たすことです。

AIプラットフォームの適材適所:3つの選択肢(SaaS / API / ローカル)

AIを導入するインフラ構成は、主に以下の3つのプラットフォームに集約されます。 これらは、Phase 1で分類した「機能配分」と密接にリンクしています。

- SaaS型(Web UI利用):迅速な検証と知見の収集 ChatGPTやGeminiなどの既製品をそのまま利用する形態です。 主に「創造的業務」における個人の壁打ちや、社内向けの先行検証に向いています。 導入コストは最小ですが、入力データの二次利用設定(オプトアウト)等の管理が不可欠です。

- API利用型(System Integration):業務フローへの組み込み Google Cloud Vertex AIやAzure OpenAIなどのAPIを自社システムへ統合する形態です。 「定型業務」の自動化など、Pythonプログラムを介した大規模な処理に真価を発揮します。 エンタープライズ版の契約により、高いデータプライバシーを確保できるのが強みです。

- ローカルLLM(On-Premise):究極の機密保持と自律性 Llama等のオープンウェイトなモデルを、Ubuntu等の自社サーバー上で動かす形態です。 外部へのデータ送信が一切許されない特殊環境や、機密コードを扱う現場で「輝く」選択肢となります。 運用体制がない組織では破綻する可能性があり、計算資源の管理コストも増大するこの選択肢ですが、モデルを独自に「調教」する自由度が得られます。

選定基準:なぜその構成にするのか

モデル選定の際、私が重視しているのは「スポーツカーでコンビニに行かない」という視点です。 全ての業務に巨大な最新モデル(GPT-4o等)を割り当てる必要はありません。 単純なテキスト分類なら軽量モデルで十分であり、それが「ROI(投資対効果)」の最大化に繋がります。

PMOや責任あるエンジニアは、技術的な好奇心を一度横に置き、「このデータプライバシー要件なら、APIではなくローカルLLMであるべきだ」といった、論理的な裏付けを持ってアーキテクチャを確定させるべきです。

Phase 2の完了は、システムとしての「箱」が決まることを意味します。 この決定が、次フェーズでの具体的な「実装(プロンプト設計)」の制約条件となります。

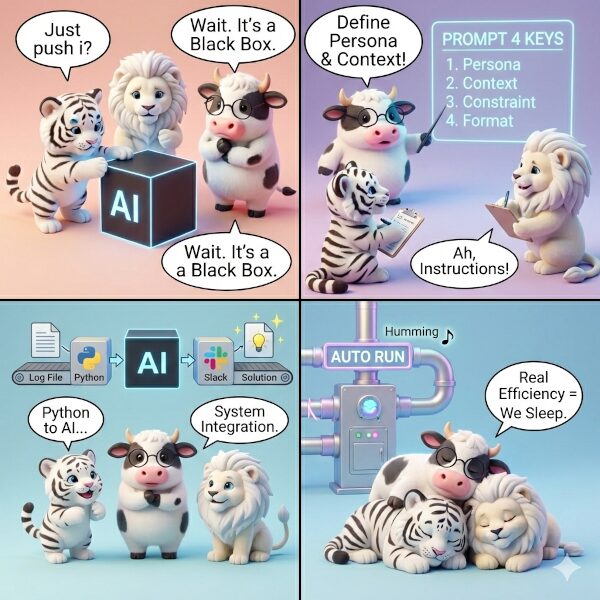

Phase 3: AI実装とプロンプト設計(業務を自動化する具体的な方法)

Phase 2で決定した「箱(インフラ)」に対し、いかに魂を吹き込み、実務を回す「歯車」へと変えていくか。 このフェーズでは、AIの性能を最大限に引き出す「プロンプト設計」と、それをシステムに組み込む「パイプラインの構築」に焦点を当てます。

プロンプト設計:属人技を「再現可能な設計技法」へ昇華させる

プロンプトとは、AIへの「お願い」ではなく、動的な出力を制御するための「引数」です。 PMやPLは、現場のエンジニアが以下の4要素を常に意識した設計を行えるよう、共通言語化すべきです。

- Persona(役割): 「あなたは5年目の中堅インフラエンジニアです」と定義し、回答の視座を固定します。なお、役割設定が曖昧なプロンプトは、出力品質の劣化だけでなく、意図しない判断代行や責任範囲の逸脱を招くリスクがあります。

- Context(背景): 「Azure環境のログから、特定の認証エラーを抽出したい」と、目的を具体化します。

- Constraint(制約): 「Markdown形式で出力し、機密情報は伏せ字にすること」と、出力の境界線を引きます。

- Output Format(形式): 「後続のプログラムで処理するため、必ずJSON形式で出力せよ」と、データ構造を指定します。

これらを「プロンプト・テンプレート」として資産化し、チーム内で共有することが、品質を安定させる鍵となります。

システム連携:Pythonによる自動化パイプラインの構築

AIとの対話は、チャット画面で終わらせてはなりません。 真の省力化は、Python等のプログラムを介してAIを既存の運用フローへ組み込むことで達成されます。

- 入力の自動化: 定期的にログファイルを取得し、前処理を行った上でAIのAPIへ流し込みます。

- 出力の構造化: AIの回答を構造データとして受け取り、後続のDB登録やレポート作成へ繋げます。

- 処理の統合: AIが得た知見を元に、Slackへのアラート通知や、初期対応のスクリプト生成を自動化します。ただし、すべてを自動実行してはなりません。判断や対外影響を伴う処理には、必ず人間の承認ステップを挟む設計が求められます。

実装における「説明責任」の準備

ここで忘れてはならないのが、次フェーズで扱う「ガバナンス」への布石です。 「どのプロンプトを、誰が、どの業務文脈で使用したか」「その結果、どの出力が、どの後続処理に渡されたか」を追跡可能にすること。 このログ記録の仕組みを実装段階でアーキテクチャに組み込んでおくことが、AI実装における最低限の説明責任です。

Phase 4: AI活用におけるガバナンスとリスク管理(安全な運用のためのルール設計)

AI導入の最終工程は、技術的な実装ではなく、それを運用し続けるための「統治(ガバナンス)」の確立です。 どれほど精緻なパイプラインを組んでも、AIは確率的に「嘘(ハルシネーション)」をつき、予測不能な挙動を見せます。 PMOやIT部門の責任者は、AIを自由放任にせず、組織の法典の中に正しく位置づけなければなりません。

責任分界点(Delineation of Responsibility)の確立

最も重要なのは、「AIの成果物に対し、誰が最終的な責任を負うのか」という境界線を引くことです。 本ロードマップでは、以下の三層構造による「実装責任」の定義を推奨します。

- AIが生成(Drafting): AIはプロンプトに従い、最速で「叩き台」を出力します。

- 人間が承認(Approval): 専門知識を持つエンジニアが内容を検証し、承認印を押します。

- 組織が責任を負う(Liability): 承認された成果物は「組織の意思」となり、AIではなく人間が責任を負います。

このプロセスを徹底するため、Phase 1で定義した「判断業務(Decision)」の自動実行を厳禁し、必ず「Human-in-the-loop(人間が介在するプロセス)」をワークフローに組み込んでください。

データプライバシーとオプトアウト設定

機密情報を扱うインフラエンジニアにとって、データの流出は致命傷となります。 「入力したデータがAIの学習に再利用されないか」という一点において、妥協は許されません。 APIの契約形態(エンタープライズ契約)や、オプトアウト設定の有無を監査し、それを「AI利用ガイドライン」として文書化することが、現場のエンジニアをリスクから守る唯一の手段です。

監査ログ:説明責任を果たすための「航海日誌」

Phase 3で準備したログ記録の仕組みを、ガバナンスの柱として機能させます。

- 入力の透明性: 誰が、いつ、どのような業務文脈でそのプロンプトを投げたか。

- 出力の検証可能性: AIがどのモデルで、どのようなパラメータ(Temperature等)でその回答を出したか。

- 承認の証跡: その回答を採用すると判断したのは誰か。

これらが追跡可能(トレーサブル)であること。それこそが、事故が起きた際に「正しく設計し、正しく運用していた」と証明するための、エンジニアにとっての最後の砦となります。

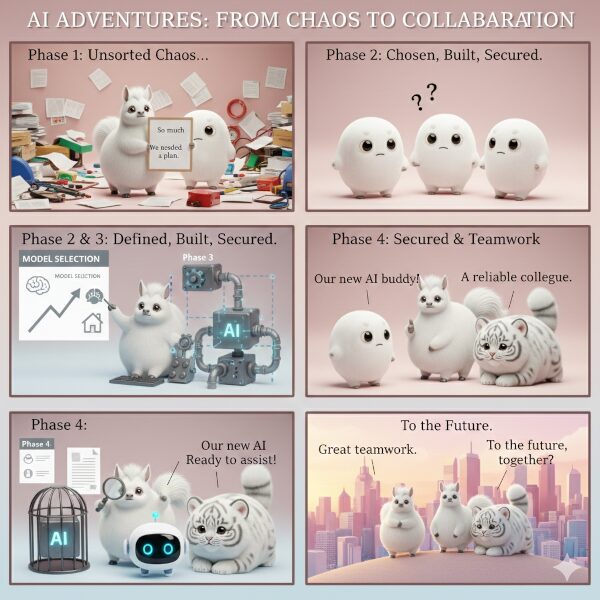

まとめ:AI活用を「一時の熱狂」で終わらせないために

| フェーズ | 役割 | 成果物 |

| Phase 1 | 思想と構造化 | 業務の3分類と機能配分の定義 |

| Phase 2 | 箱と環境設計 | 最適なプラットフォームの選定 |

| Phase 3 | 実装と管制 | 再現可能なプロンプト資産と自動化 |

| Phase 4 | 統治と防御 | 責任分界点の明文化と監査体制 |

この設計図が、AIという強力な「同僚」を迎え入れる皆さんの、確かな拠り所となることを願っています。

AI活用ロードマップ

コメントを残す